اگر شما در مورد چگونگی اطمینان از اینکه صفحات وب سایت شما کرال شوند، مطمئن نیستید، چندین اقدام مهم برای این منظور وجود دارد. از جمله ایجاد استراتژی های لینک داخلی تا راهنمایی گوگلبات، اولویت بخشیدن به این مراحل میتواند به بهبود قابلیت رؤیت وب سایت شما در سطوح گوگل کمک کند. بدون در نظر گرفتن اندازه وب سایت شما، کرالینگ از اهمیت بسیاری برخوردار است؛ زیرا بدون آن، محتوای شما برای مخاطبان پتانسیل قابل مشاهده نخواهد بود. برای افزایش دیده شدن محتوای شما، نحوه خزیدن در سایت امری حیاتی است.

در این مقاله برای شما خواهیم گفت از:

- خزیدن در سئو چیست؟

- خزیدن وب چگونه کار می کند؟

- چرا مهم است که سایت شما قابل خزیدن باشد؟

- اندازه گیری Crawl : خزیدن بودجه در مقابل کارایی خزیدن

- پشتیبانی موتور جستجو برای خزیدن

- نحوه دستیابی به کرال کارآمد سایت

1.خزیدن در سئو چیست؟

در حوزه بهینهسازی موتورهای جستجو، کرالینگ به فرآیند سیستماتیک مربوط میشود که در آن باتهای موتورهای جستجو، همچنین شناورهای وب یا عنکبوتها، محتواهای موجود در یک وبسایت را کشف میکنند. این محتوا میتواند از انواع مختلفی باشد، مانند متن، تصاویر، ویدئوها یا سایر نوع فایلهایی که برای باتها قابل دسترس هستند. با این حال، تمامی محتواها فقط از طریق لینکها پیدا میشوند، بنابراین داشتن یک ساختار لینک داخلی قوی برای کرالینگ و ایندکس کردن موثر وبسایت شما بسیار حیاتی است.

مقاله بودجه خزش چیست را مطالعه کنید.

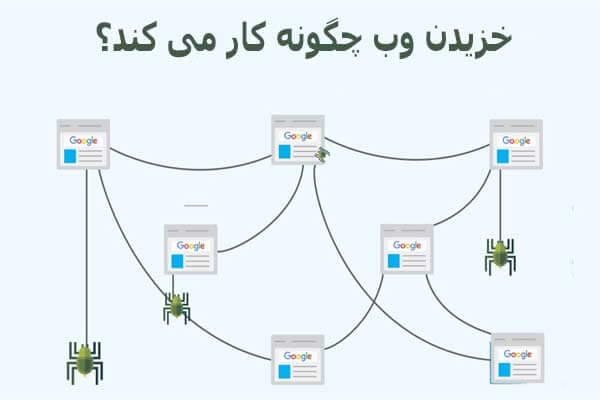

2.خزیدن وب چگونه کار می کند؟

یک وب کرالر با کشف آدرس های URL و بارگیری محتوای مربوطه عمل میکند. در طول این فرآیند، کرالر لینکهایی را به صفحات دیگر وب پیدا میکند و محتوای آن صفحات را به ایندکس موتور جستجو منتقل میکند. لینکهای پیدا شده به چندین نوع تقسیم میشوند:

– آدرسهای URL جدیدی که برای موتور جستجو ناشناخته هستند.

– آدرسهای URL شناخته شده که نیاز به بازدید دورهای دارند تا تعیین شود آیا تغییری در محتوای صفحه صورت گرفته است و به این ترتیب ایندکس موتور جستجو باید بهروزرسانی شود.

– آدرسهای URL شناخته شده که بهروزرسانی شدهاند و راهنمایی واضحی داده شده است. آنها باید دوباره Crawl شده و بهروزرسانی شوند، مانند از طریق برچسب زمان آخرین بهروزرسانی در نقشه سایت XML.

– آدرسهای URL شناخته شده که بهروزرسانی نشدهاند و راهنمایی واضحی داده شده است. آنها نباید دوباره Crawl شوند یا بهروزرسانی شوند، مانند شیرینگ HTTP 304 موجود نیست.

– آدرسهای URL غیرقابل دسترس که نمیتوان یا نباید پیگیری شوند، به عنوان مثال آدرسهایی که در پشت یک فرم ورود به سیستم هستند یا لینکهایی که توسط برچسب رباتهای “nofollow” مسدود شده اند.

– آدرسهای URL غیرمجاز که باتهای موتور جستجو آنها را Crawl نخواهند کرد، به عنوان مثال آدرسهایی که توسط فایل robots.txt مسدود شدهاند.

– تمام آدرسهای URL مجاز به لیست صفحاتی که در آینده باید بازدید شوند، یعنی صفحات کرال، اضافه میشوند. با این حال، آنها بر اساس چندین عامل درجهبندی شده و اولویتهای مختلفی به آنها داده میشود که تعیین میکند کدام صفحه مهمتر است.

– بیشترین موتورهای جستجو باتهای خود را دارند که از الگوریتمهای خاص برای تعیین آنچه خزیدن میکنند و زمان آن استفاده میکنند، بدین معنی که همه باتها به یک شکل کرال نمیکنند. به عنوان مثال، گوگلبات به طور متفاوتی از بینگبات، داکداکبات، یاندکس بات و یا یاهو اسلورپ عمل میکند.

3.چرا مهم است که سایت شما قابل خزیدن باشد؟

صفحاتی که Crawl نشوند، نه تنها در نتایج جستجو رتبهبندی نمیشوند، بلکه اهمیت کراولینگ بسیار بیشتر از این است. کرالینگ سریع برای محتوای زمانبندی شده بسیار حیاتی است، زیرا عدم کرال و دیده شدن سریع این محتوا میتواند آن را برای کاربران بیاثر کند.

به عنوان مثال، اخبار شکستناپذیر یا محصولاتی که دیگر موجود نیستند، جذب مخاطبین نخواهند کرد. با این حال، حتی برای صنایعی که به زمان حساس نیستند، کرالینگ سریع همچنان مزیت دارد.

وقتی یک مقاله بهروزرسانی میشود یا تغییرات مهم سئو در صفحه ایجاد میشود، هرچه گوگلبات آن را زودتر خزیدن کند، سریعتر از بهینهسازی بهره خواهید برد یا هر گونه اشتباه را که وجود دارد شناسایی کرده و به سرعت برگردانید. بدون Crawl سریع، نمیتوانید سریع شکست بخورید. بنابراین، کرالینگ پایهای سئو است و دیدپذیری طبیعی شما کاملاً به اجرای درست آن در وبسایت شما بستگی دارد.

4.اندازه گیری Crawl : خزیدن بودجه در مقابل کارایی خزیدن

با وجود باور رایج، هدف گوگل از کرال کردن و ایندکس کردن تمام محتوای تمام وبسایتها در اینترنت نیست. در واقع، Crawlکردن یک صفحه تضمین شده نیست و بسیاری از وبسایتها بخش قابل توجهی از صفحاتی را دارند که هرگز توسط گوگلبات خزیده نشدهاند.

اگر در گزارش ایندکس صفحات کنسول جستجوی گوگل، مشاهده کنید که بخش “کشف شده – در حال حاضر ایندکس نشده است” وجود دارد، این مشکل بر روی وبسایت شما تأثیر میگذارد. با این حال، اگر این مستثنی را نبینید، به معنایی نیست که مشکلات کرالینگی ندارید. یک اشتباه شایع درباره معیارهای مهمی که در ارزیابی عملکرد کرالینگ مؤثر هستند، وجود دارد.

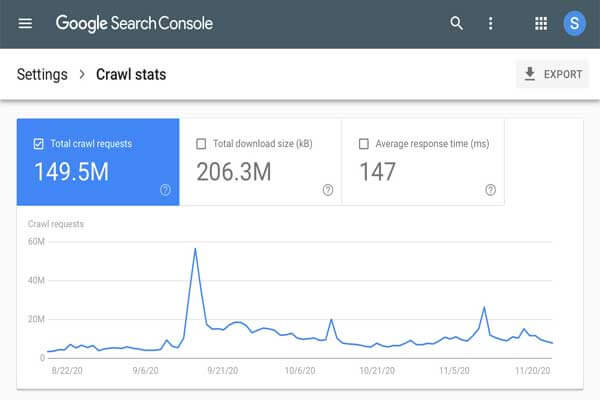

اشتباه بودجه کرال

حرفهایهای سئو مفهوم بودجه خزیدن را مد نظر دارند که به تعداد URLهایی اشاره دارد که گوگلبات میتواند در یک بازه زمانی مشخص برای یک وبسایت خاص Crawl کند. این مفهوم بر اهمیت حداکثر کردن کرالینگ تأکید میکند، همانطور که در گزارش وضعیت Crawl در کنسول جستجوی گوگل که تعداد کل درخواستهای خزیدن را نشان میدهد، مشاهده میشود.

با این حال، این ایده که بیشتر کرالینگ به طور ذاتی بهتر است، اشتباه است. تعداد کل کرالینگها فقط یک معیار ظاهری است که با بازنمایی سریعتر محتوای مهم برای شما همراستا نیست. در عوض، تنها منجر به بار بیشتر سرور و هزینههای بالاتر میشود. تمرکز باید هرگز بر افزایش کل مقدار کرالینگ نباشد، بلکه بر کرالینگ با کیفیت برای ایجاد ارزش سئو تمرکز کنید.

ارزش اثربخشی Crawl

خزیدن با کیفیت شامل کاهش زمان بین انتشار یا بهروزرسانی مهم صفحاتی است که با سئو مرتبط هستند و بازدید بعدی گوگلبات. این تأخیر به عنوان کارایی خزیدن شناخته میشود. برای تعیین کارایی کرالینگ، توصیه میشود که مقدار تاریخ ایجاد یا بهروزرسانی شده را از پایگاه داده استخراج کرده و آن را با زمان بعدی Crawl گوگلبات از URL در فایلهای لاگ سرور مقایسه کنید.

اگر این کار ممکن نیست، میتوانید آن را با استفاده از تاریخ lastmod در نقشه سایت XML محاسبه کرده و به طور دورهای با استفاده از API بررسی URL کنسول جستجوی گوگل، به آدرسهای مربوطه پرسوجو کنید تا وضعیت آخرین کرال را بازگرداند. با اندازهگیری تأخیر زمانی بین انتشار و خزیدن، میتوانید تأثیر بهینهسازی کرالینگ را با یک معیار معنادار اندازهگیری کنید.

هرچه کارایی کرالینگ کاهش یابد، محتوای جدید یا بهروزرسانی شده مرتبط با سئو بر روی سطوح گوگل برای مشاهده بیشتری زمان بیشتری نیاز دارد که به دیدپذیری وبسایت شما تأثیر میگذارد.

اگر نمره کارایی کراولینگ وبسایت شما نشان میدهد که گوگلبات برای بازدید از محتوای مهم، زمان زیادی را صرف میکند، چندین راه برای بهینهسازی خزیدن وجود دارد. این شامل بهبود ساختار پیوند داخلی وبسایت، بهروزرسانی مرتب نقشه سایت XML، اطمینان از این که فایل robots.txt وبسایت اجازه خزیدن صفحات مربوطه را میدهد و کاهش محتوای تکراری است.

علاوه بر این، بهینهسازی زمان پاسخ سرور و کاهش زمان بارگذاری صفحات نیز میتواند به بهبود کارایی کرالینگ کمک کند.

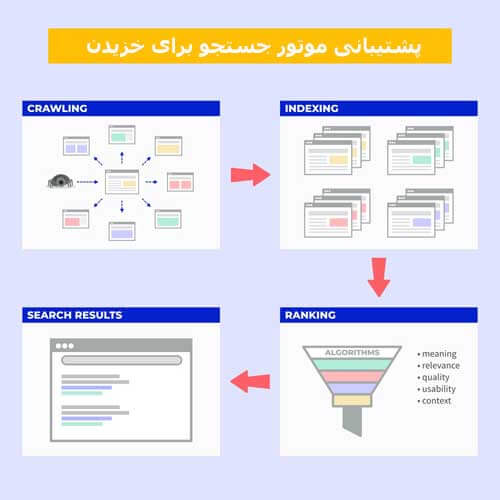

5.پشتیبانی موتور جستجو برای خزیدن

در سالهای اخیر، بسیاری از بحثها در مورد بهبود کراولینگ صورت گرفته است، زیرا این بهترین منافع برای موتورهای جستجو و شرکای آنها است. خزیدن کارآمدتر، دسترسی به محتوای بهتری را برای قدرت بخشیدن به نتایج جستجو فراهم میکند و از گازهای گلخانهای کاسته میشود که به برنامههای اکوسیستم جهان کمک میکند. بسیاری از بحثها بر روی دو API به منظور بهینهسازی کرالینگ تمرکز داشتهاند.

API اول به وبسایتها امکان میدهد تا URLهای مربوطه را مستقیماً به موتورهای جستجو ارسال کنند تا کرال شود، به جای اینکه به عنوان شبکهعنکبوتی گوگل تصمیم بگیرد کدام URLها را Crawl کند. این رویکرد به شما این امکان را میدهد تا محتوای جدیدتان را به سرعت ایندکس کنید و راهی برای حذف موثر URLهای قدیمی فراهم میکند، که در حال حاضر توسط موتورهای جستجو بهخوبی پشتیبانی نمیشود.

API دوم برای کمک به وبسایتها در مدیریت بودجه خزیدن بهطور موثر طراحی شده است، با ارائه اطلاعاتی در مورد URLهایی که Crawl میشوند و کدامها نمیشوند. این اطلاعات میتواند به شما در تصمیمگیری در مورد صفحاتی که برای کرالینگ بهینهسازی شوند و صفحاتی که مستثنی شوند، کمک کند.

بهطور کلی، این APIها فرصتهای جذابی برای بهبود کراولینگ و ایندکسکردن محتوا ارائه میدهند، که نتایج بهتری را برای کاربران موتورهای جستجو و مالکان وبسایت به ارمغان میآورد.

پشتیبانی غیر Google از IndexNow

در مورد API اول که IndexNow نام دارد، باید گفت که این API توسط بینگ، یاندکس و سیزنام پشتیبانی میشود اما توسط گوگل پشتیبانی نمیشود. همچنین این API در بسیاری از ابزارهای SEO، CRM و CDN هم یکپارچه شده است که ممکن است نیاز به تلاش توسعهای کمتری برای بهرهبرداری از IndexNow داشته باشد. این ممکن است به نظر برنامهریزی سریع برای بهبود سئو بیاید، اما لازم است مراقب باشید.

مهم است که در نظر داشته باشید که آیا بخش قابل توجهی از مخاطبان هدف شما از موتورهای جستجوی پشتیبانی شده توسط IndexNow استفاده میکنند یا خیر. اگر خیر، فعالسازی Crawlها از بوتهای آنها ممکن است ارزش محدودی داشته باشد. علاوه بر این، ارزیابی کردن اینکه ادغام در IndexNow چه تأثیری بر وزن سرور در مقابل بهبود نمره کارایی کراول برای آن موتورهای جستجو دارد، بسیار مهم است. ممکن است هزینه ها ارزش سود را نداشته باشند.

به طور کلی، هر چند IndexNow میتواند به عنوان یک ابزار مفید برای برخی از وبسایتها باشد، اما مهم است قبل از ادغام آن در استراتژی سئو خود، هزینهها و مزایا را به دقت ارزیابی کنید.

پشتیبانی گوگل از API Indexing

API دوم که Google Indexing API نام دارد، تنها برای کرال صفحات با نشانگرهای مشخص شده برای اطلاعات شغلی یا رویدادهای پخش شده کاربرد دارد، به عبارت دیگر برای اینکه این دو نوع از صفحات را Crawl کند. با این حال، برخی افراد این را تست کردهاند و متوجه شدهاند که این بیانیه غلط است.

ارسال URLهایی که با این مشخصات مطابقت ندارند به Google Indexing API میتواند منجر به افزایش قابل توجهی در کرال شدن شود، اما این یک مثال کامل از این است که چرا “بودجه کراولینگ بهینه” و تصمیم گیری بر اساس میزان کراولینگ میتواند گمراه کننده باشد.

برای URLهایی که با این مشخصات مطابقت ندارند، ارسال آنها به API هیچ تأثیری بر روی ایندکس کردن ندارد. وقتی به آن فکر میکنید، این به طور کامل منطقی است، زیرا شما تنها یک URL را ارسال میکنید و گوگل به سرعت صفحه را Crawl میکند تا ببیند آیا دادهی ساختار یافته مشخص شده را دارد یا خیر.

بنابراین، فراخوانی API برای صفحاتی که با مشخصات مطابقت ندارند، بار غیرضروری را بر روی سرور شما افزایش میدهد و منابع توسعه را بدون هیچ سودی تلف میکند.

به طور خلاصه، هر چند Google Indexing API میتواند برای وبسایتهایی با نشانگرهای اطلاعات شغلی یا رویدادهای پخش شده، به یک ابزار مفید تبدیل شود، اما ارسال URLهایی که با این مشخصات مطابقت ندارند به API، احتمالاً بهبود ایندکس کردن را به دنبال ندارد و حتی ممکن است عملکرد وبسایت شما را به خطر بیاندازد. بنابراین، مهم است تصمیمات خود را بر اساس اثربخشی Crawling و سایر معیارهای معنیدار، نه فقط میزان Crawling بگیرید.

پشتیبانی گوگل در کنسول جستجوی گوگل

در مورد روش دیگری که گوگل برای کرال کردن صفحات ارائه میدهد، باید به ارسال دستی از طریق Google Search Console اشاره کرد. بیشتر URLهایی که به این شیوه ارسال میشوند، در عرض یک ساعت کرال شده و وضعیت ایندکس کردن آنها تغییر خواهد کرد.

با این حال، یک محدودیت کوتاهی وجود دارد و آن هم حداکثر 10 URL در 24 ساعت است، بنابراین مشکل این تاکتیک مربوط به مقیاس است. با این حال، مهم است که به آن توجه کنید و آن را نادیده نگیرید.

یکی از روشهای بهرهبرداری از ارسال دستی، اتوماسیون ارسال URLهای اولویتی از طریق اسکریپت نویسی است که عملکرد کاربر را تقلید میکند تا Crawling و ایندکس کردن برای آن اندکی انتخاب شده، سریعتر انجام شود. این رویکرد میتواند به کردن محتوای حیاتی سریعتر کمک کند، بدون اینکه محدودیت کوتاهی را نادیده بگیرد.

لازم به ذکر است که بر اساس آزمایشات فعلی، کلیک کردن دکمه “تأیید رفع مشکل” در برگرداندن استثنائات “در حال حاضر شناسایی نشده”، به شدت کرالینگ را تسریع نمیکند.

در مورد چگونگی کمک به خودمان در کراولینگ، چندین راهکار وجود دارد که باید به آنها توجه کنیم. این شامل بهبود ساختار و پیوند داخلی وبسایت است تا موتورهای جستجو بتوانند محتوا را به طور کارآمد Crawl کنند، بهینهسازی زمان بارگذاری صفحات، کاهش محتوای تکراری و بهروزرسانی منظم نقشه سایت XML است. علاوه بر این، نظارت منظم بر کارایی خزیدن و اعمال تغییرات لازم میتواند به بهبود عملکرد Crawling و ایندکس کردن کمک کند.

6.نحوه دستیابی به کرال کارآمد سایت

- برای کراولینگ کارآمد، اطمینان از پاسخ سرور سریع و سالم: یک سرور بسیار عملکرد بالا برای کرالینگ کارآمد بسیار حیاتی است. این باید بتواند تعداد کرالینگهایی که Googlebot میخواهد انجام دهد را بدون هیچ تأخیر یا خطا اجرا کند.

باید وضعیت سایت میزبان خود را در Google Search Console بررسی کرده و اطمینان حاصل کرد که خطاهای 5xx کمتر از 1٪ و زمان پاسخ سرور کمتر از 300 میلیثانیه است. این کمک میکند تا Googlebot بدون تأخیر یا خطا میتواند سایت شما را کرال کند. به علاوه، نظارت منظم بر عملکرد سرور و رفع مشکلات به سرعت میتواند به بهبود عملکرد کراولینگ و ایندکس کردن کمک کند.

- حذف محتوای بی ارزش: وقتی قسمت قابل توجهی از محتوای یک وبسایت کیفیت پایین، قدیمی یا تکراری باشد، این موضوع باعث میشود Crawlها از بازدید محتوای جدید یا بهروزشده منحرف شوند و به افزایش حجم ایندکس کمک کنند. برای حل این مشکل، لازم است محتوای بی ارزش را از وبسایت خود حذف کنید.

یکی از راههای شروع به پاکسازی، بررسی گزارش صفحات Google Search Console برای استثناء “Crawled – currently not indexed” است. در نمونههای ارائه شده، الگوهای پوشه یا سایر نشانههای مشکل را بررسی کنید. برای آنهایی که پیدا کردید، با ادغام محتوای مشابه با یک تغییر مسیر 301 یا حذف محتوا با یک خطای 404، مشکل را برطرف کنید. این کمک میکند تا Crawlها بتوانند به محتوای قابل ارزش و مربوط تمرکز کنند و حجم ایندکس را کاهش دهند.

نظارت منظم و بهروزرسانی محتوای سایت شما همچنین میتواند کمک کند تا محتوا همچنان برای مخاطبین شما قابل ارزش و مربوط باشد و عملکرد کرالینگ و ایندکس کردن را به مرور بهبود بخشد. به علاوه، اجرای تدابیری برای جلوگیری از محتوای تکراری، مانند URLهای کانونیکال و برچسبهای متا، میتواند به خزیدن و ایندکس کردن موثر وبسایت شما کمک کند.

- آموزش Googlebot که چه چیزی را کرال نکند: در حالی که پیوندهای rel=canonical و برچسبهای noindex موثر در حفظ ایندکس Google از وبسایت شما هستند، آنها همچنین ممکن است برای شما در کراولینگ هزینه داشته باشند.

لذا این مهم است که در نظر داشته باشید آیا باید ابتدا صفحات کرال شوند یا خیر. اگر نه، میتوانید با استفاده از یک فایل robot.txt disallow، Google را در مرحله کراولینگ متوقف کنید.

برای پیدا کردن مواردی که مسدود کردن کرالر بهتر از دادن دستورات ایندکسینگ است، در گزارش پوشش Google Search Console برای استثناءهای از canonicals یا برچسبهای noindex جستجو کنید.

همچنین، نمونههای URLهای “Indexed, not submitted in sitemap” و “Discovered – currently not indexed” در Google Search Console را مرور کنید و مسیرهای غیر مربوط به SEO مانند صفحات پارامتر، صفحات عملکردی (مانند “سبد خرید”)، فضاهای نامحدود ایجاد شده توسط صفحات تقویم، تصاویر غیرمهم، اسکریپتها و فایلهای استایل و URLهای API را پیدا کرده و مسدود کنید.

همچنین، مهم است که به این نکته توجه کنید که راهبرد صفحهبندی شما چگونه بر خزیدن تأثیر میگذارد. پیادهسازی یک راهبرد صفحهبندی که از برچسبهای rel=next و rel=prev استفاده میکند، میتواند به Googlebot کمک کند تا محتوای وبسایت شما را به طور موثرتر بخزد و مشکلات محتوای تکراری را از بین ببرد.

در کل، بررسی و بهروزرسانی منظم فایل robot.txt و دستورات دیگر به Googlebot برای اطمینان از اینکه فقط محتوای قابل ارزش و مربوط را کرال میکند و روی صفحات با کیفیت پایین یا غیرمهم منابع خود را تلف نمیکند، بسیار مهم است.

- آموزش Googlebot در مورد چه چیزی و چه زمانی را Crawl کردن : یک نقشه سایت XML بهینهشده، ابزار موثری است برای هدایت Googlebot به سمت URLهای مربوط به SEO. مهم است که نقشه سایت را بهینهسازی کنید تا اطمینان حاصل شود که با تأخیر کمی بهروزرسانی شود و تاریخ و زمان آخرین تغییرات را شامل شود تا به موتورهای جستجو اطلاع داده شود که صفحه آخرین بار کی تغییر یافته است و آیا باید دوباره کرال شود یا خیر.

بهروزرسانی منظم نقشه سایت شما میتواند به اطمینان از اینکه Googlebot از محتوای جدید یا بهروزرسانی شده وبسایت شما آگاه شده و به طور موثر آن را کراول میکند، کمک کند.

علاوه بر این، اجرای تدابیری مانند پیادهسازی تأخیر خزیدن در فایل robots.txt شما میتواند به اطمینان از اینکه Googlebot با نرخی که برای سرور شما بهینه است، محتوای وبسایت شما را Crawl میکند و از بارگذاری زیاد جلوگیری کند، کمک کند.

همچنین، مهم است که به طور منظم کارایی کرال را نظارت کرده و نقشه سایت و دستورالعملهای Crawling خود را بهطور لازم بهروزرسانی کنید تا به اطمینان از اینکه Googlebot محتوای قابل ارزش و مربوط را در وبسایت شما کراول میکند، کمک کنید.

با آموزش Googlebot در مورد چه چیزی را کرال کردن و کی، میتوانید به بهبود عملکرد کراولینگ و ایندکس کردن کمک کنید، که منجر به دیداری بهتر در موتورهای جستجو و جذب ترافیک بیشتر میشود.

- حمایت از خزیدن از طریق لینکهای داخلی: ما میدانیم که خزیدن فقط از طریق لینکها امکان پذیر است. در حالی که نقشه سایت XML یک مکان عالی برای شروع است، لینکهای خارجی ممکن است برای ساختن به صورت عمده و با کیفیت چالش برانگیز باشند. از سوی دیگر، لینکهای داخلی نسبتاً آسان برای اندازهگیری هستند و تأثیرات مثبت قابل توجهی روی کرالینگ دارند.

برای حمایت از کراولینگ از طریق لینکهای داخلی، مهم است توجه ویژهای به نویگیشن سایت موبایل، breadcrumbs، فیلترهای سریع و لینکهای مرتبط با محتوا داشته باشید. مطمئن شوید که هیچ کدام به Javascript وابسته نیستند، زیرا Googlebot ممکن است نتواند آنها را کرال کند.

به علاوه، نظارت منظم بر کارایی کرالینگ و تنظیم لینکدهی داخلی به عنوان نیازمندیهای کرالینگ، میتواند به اطمینان از اینکه Googlebot محتوای قابل ارزش و مربوط را در وبسایت شما Crawl میکند، کمک کند.

با حمایت از Crawling از طریق لینکهای داخلی، میتوانید به بهبود عملکرد خزیدن و ایندکس کردن کمک کنید، که منجر به دیداری بهتر در موتورهای جستجو و جذب ترافیک بیشتر میشود.